掌握robots.txt文件的撰写艺术

在构建和优化网站的过程中,`robots.txt` 文件扮演着至关重要的角色。这个文件是网站与搜索引擎蜘蛛之间的通信桥梁,告诉搜索引擎哪些页面可以爬取,哪些页面应该被忽略。正确地编写 `robots.txt` 文件不仅能保护网站内容不被误爬,还能提升搜索引擎优化(SEO)效果。以下是一份详细指南,旨在帮助你了解如何编写一个高效、清晰的 `robots.txt` 文件。

一、`robots.txt` 文件概述

`robots.txt` 文件位于网站的根目录下,其路径通常为 `http://yourdomain.com/robots.txt`。这个文件包含了一系列指令,用于指导搜索引擎爬虫(spider)访问和索引网站内容的行为。尽管这些指令并非强制性,但遵循它们对于维护网站安全和隐私至关重要。

二、编写 `robots.txt` 文件的基本规则

1. 文件格式:`robots.txt` 文件必须采用纯文本格式,编码建议使用 UTF-8。

2. 语法结构:

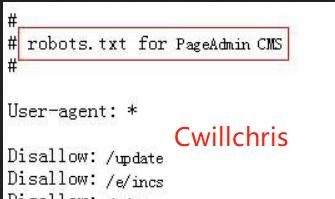

User-agent:指定指令适用的搜索引擎爬虫。`*` 表示所有爬虫。

Disallow:列出不希望被爬取的URL路径。

Allow(可选):在某些情况下,可以明确指定允许爬取的路径,尽管这不是所有搜索引擎都支持。

3. 注释:使用 `` 符号添加注释,以提高文件可读性。注释不会被搜索引擎爬虫执行。

三、示例与详解

示例1:基础配置

```

User-agent:

Disallow: /private/

Disallow: /tmp/

```

这个简单的 `robots.txt` 文件禁止所有搜索引擎爬虫访问 `/private/` 和 `/tmp/` 目录下的内容。

示例2:针对特定搜索引擎

```

User-agent: Googlebot

Disallow: /search/

User-agent: Bingbot

Disallow: /images/

```

在这个例子中,`Googlebot` 被禁止访问 `/search/` 目录,而 `Bingbot` 被禁止访问 `/images/` 目录。其他搜索引擎爬虫不受这些指令限制。

示例3:允许与禁止混合使用

```

User-agent:

Disallow: /admin/

Allow: /blog/

```

虽然这个文件对所有搜索引擎爬虫生效,但它禁止访问 `/admin/` 目录,同时允许访问 `/blog/` 目录。需要注意的是,`Allow` 指令的有效性取决于搜索引擎是否支持该指令。

四、高级用法与注意事项

1. 路径匹配规则:

`Disallow: /folder/` 会阻止访问 `/folder/` 及其所有子目录。

`Disallow: /folder/page.html` 仅阻止访问特定的文件,不影响其他页面。

`Disallow: /` 会阻止访问整个网站,这是一个极端的例子,通常不推荐使用。

2. 通配符使用:某些搜索引擎支持通配符,如 `$` 表示字符串结束,`*` 表示任意字符序列。然而,并非所有搜索引擎都支持这些高级特性,因此在编写时应谨慎。

3. sitemap 引用:

```

User-agent:

Sitemap: http://yourdomain.com/sitemap.xml

```

虽然 `robots.txt` 文件的主要功能是控制爬虫访问,但你也可以在其中提供 sitemap 的链接,帮助搜索引擎更有效地索引网站内容。

4. 测试与验证:

使用在线工具如 Google Search Console 的 Robots.txt 测试工具来验证 `robots.txt` 文件的有效性。

定期检查爬虫访问日志,确保 `robots.txt` 文件的指令被正确执行。

5. 安全考虑:

避免在 `robots.txt` 文件中泄露敏感信息,如后台登录地址。

定期更新 `robots.txt` 文件,以适应网站结构的变化。

五、常见问题解答

Q1:`robots.txt` 文件是否影响网站的SEO?

A:是的。正确的 `robots.txt` 文件配置可以防止搜索引擎索引不必要的页面,如临时文件、测试页面或敏感数据,从而提升网站的整体SEO表现。

Q2:如果 `robots.txt` 文件配置错误,会有什么后果?

A:配置错误的 `robots.txt` 文件可能导致搜索引擎无法正确索引网站内容,甚至完全无法访问网站。因此,建议定期检查和测试 `robots.txt` 文件。

Q3:`robots.txt` 文件和 meta noindex 哪个更重要?

A:两者各有作用。`robots.txt` 文件主要用于控制搜索引擎爬虫的访问权限,而 meta noindex 则用于在页面级别上阻止内容被索引。两者可以结合使用,以实现更精细的控制。

Q4:是否每个网站都需要 `robots.txt` 文件?

A:虽然 `robots.txt` 文件不是强制性的,但对于大多数网站来说,拥有一个明确的 `robots.txt` 文件是一个好习惯。它可以保护敏感内容不被误爬,同时也有助于提高网站的SEO效果。

六、总结

`robots.txt` 文件是网站与搜索引擎之间的重要通信工具。通过正确地编写和配置这个文件,你可以有效地控制搜索引擎爬虫的行为,保护网站内容的安全和隐私,同时提升网站的SEO表现。记住,定期检查和更新 `robots.txt` 文件是保持网站健康运行的关键。希望这篇指南能帮助你更好地理解 `robots.txt` 文件的编写和使用。

- 上一篇: 留学生回国后如何进行学历认证?

- 下一篇: 探寻2013年高考成绩的查询之道

-

掌握写证明的标准格式与范文示例资讯攻略11-30

掌握写证明的标准格式与范文示例资讯攻略11-30 -

轻松掌握!贷款申请书撰写指南资讯攻略12-07

轻松掌握!贷款申请书撰写指南资讯攻略12-07 -

掌握eMule使用技巧,轻松畅享文件共享之旅资讯攻略11-12

掌握eMule使用技巧,轻松畅享文件共享之旅资讯攻略11-12 -

如何撰写结算单资讯攻略11-06

如何撰写结算单资讯攻略11-06 -

如何撰写个人职业选择意向资讯攻略12-06

如何撰写个人职业选择意向资讯攻略12-06 -

打造完美发言:掌握发言稿的正确格式资讯攻略11-12

打造完美发言:掌握发言稿的正确格式资讯攻略11-12